OCR+RAG组合拳:专有模型如何加速LLM智能感知?

从 DeepSeek R1 的发布到多模态 Agent 的持续演进,大语言模型(LLM)正以前所未有的速度拓展人工智能的能力边界。曾经被视为“专用工具”的小模型似乎面临被统一替代的局面。于是一个问题浮出水面:在LLM几乎可以处理所有任务的今天,像OCR这样的专有模型还有必要存在吗?

本文将从模型能力划分、大模型与OCR的协同关系、以及典型应用场景出发,探讨OCR在智能文档处理中的核心角色与不可替代性。

一、大模型与小模型的区别?

目前学界与产业界对于大模型与小模型的划分,主要依据参数规模与应用广度。从参数数量上看,通常将小于1B(甚至0.1B)的模型归类为小模型;从任务类型上看,专注于特定目标的模型(如OCR、人脸识别、语音识别)被认为是小模型,而面向通用任务、具备泛化能力的模型则属于大模型。因此,OCR模型通常具备参数小、聚焦单一任务、结构精简的特征,但在特定应用场景下,其精度与性能往往优于大模型所能提供的通用能力。

二、小模型会被大模型取代吗?

从产业应用角度看,业界主流观点认为:大模型与小模型将长期共存。大模型主导认知与推理,小模型负责感知与输入。OCR即是典型的小模型代表,专注文档结构感知与字符识别,支撑大模型完成后续的信息抽取与问答生成。小模型不仅不会被大模型取代,反而会与大模型形成1+1>2的协同效应。

三、LLM具备OCR能力,为何仍需专有模型?

OCR的作用是将文档图像中的自然语言内容转化为结构化的电子数据,使“人类可读”信息变为“机器可读”信息,为后续的抽取、问答、知识构建提供基础输入。

虽然当下部分LLM具备基本的OCR能力,但在架构设计上,它们并不以多模态为主。例如,DeepSeek 本身并未支持图像输入,而是依靠外接 OCR 小模型实现文字图像识别。这种分工体现了当前LLM的能力边界:大模型在处理复杂、泛化的语言任务方面具备优势,但在需要高度结构还原与精度保证的专有场景中,仍无法替代OCR模型。

此外,大模型的“幻觉问题”亦是重要制约因素。视觉大模型的生成机制基于概率推断,其输出依赖训练数据与输入图像特征,存在“合理但不真实”的可能。而OCR模型(如基于ViT架构)则以重建图像文字为目标,确保输出结果与原图一致,不会产生内容幻觉。这种机制上的根本区别决定了OCR模型在高准确度场景下的可靠性优势。

四、大小模型协同的典型路径:OCR+RAG

在文档类智能系统中,大小模型之间的协同正在成为主流架构。以RAG(Retrieval-Augmented Generation,检索增强生成)为例,大模型通过对外部知识库的检索增强实现高质量问答生成,而OCR文档解析模型则负责对文档原始内容的准确识别与结构还原。

具体而言,在与大模型系统集成时,OCR模块作为前置感知入口,输出具备逻辑顺序的文本结构,确保信息输入的一致性与准确性,显著降低后续生成阶段的信息偏差与幻觉概率。尤其在RAG类知识问答系统中,OCR模型的结构还原能力直接影响文档片段检索的上下文准确性,是提升大模型推理能力的基础保障。

五、合合信息OCR模型在大模型架构中的价值定位

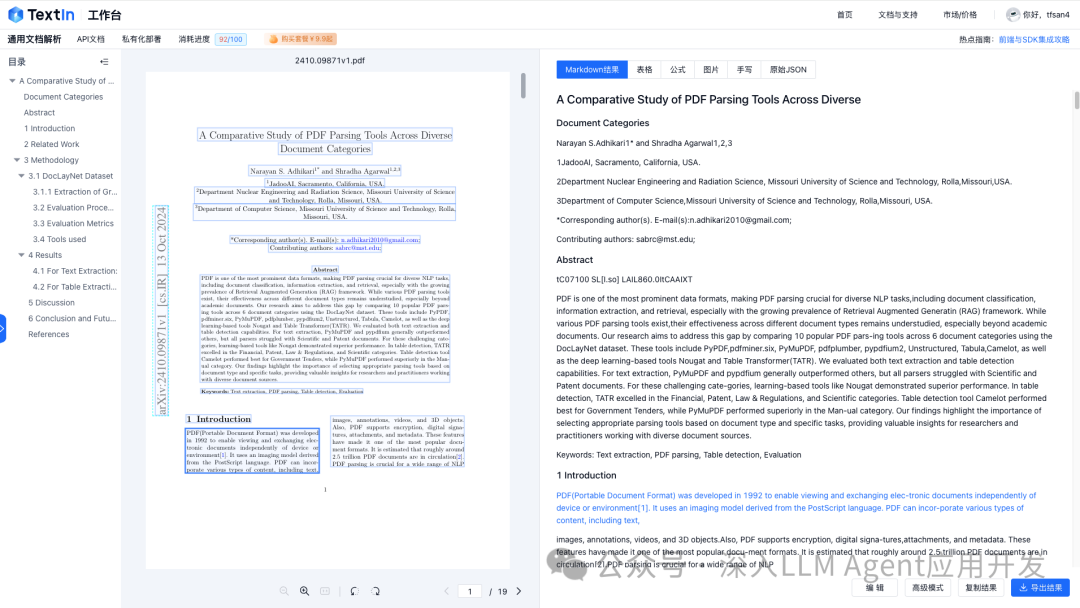

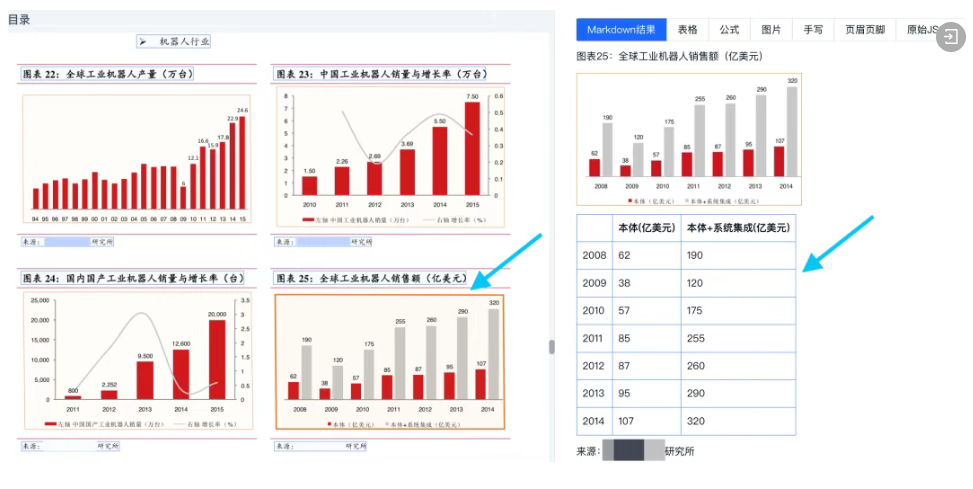

在合合信息的智能文档解决方案中,OCR不仅仅是字符识别工具,更是连接非结构化图像与结构化语义之间的关键桥梁。合合信息自研OCR专有模型具备高度定制化与垂直适配能力,支持段落、表格、多列、标题、公式等多类型文档元素的结构化解析,已广泛应用于合同、审批文书、财报报表、扫描档资料等场景。

通过高精度、低延迟、可部署的OCR模型能力,合合信息正在为大模型的企业级应用落地提供底层感知支持,实现从文档“可见”到“可理解”的转变。这种感知-认知协同架构,也将成为智能文档系统在未来数年持续演化的核心方向。

大模型引领AI系统从感知走向认知,但离不开以OCR为代表的小模型完成“信息输入”这一关键任务。未来,OCR将以更轻量的架构、更专业的能力、更强的文档适配性,在企业级应用中持续发挥核心价值。