多模态文档解析如何做到“图文共读”?合合信息这样做

一份年报中同时包含正文分析、利润趋势图、资产负债表、风险评级分布图……开发者需要提取出关键财务指标并进行结构化建模,供下游分析系统或大模型调用。此时若只识别文字,表格数据就会缺失;只提图像,又看不到语义。图与文各唱各的戏,下游系统难以“对号入座”。这类场景在政务、医疗、制造、科研等行业屡见不鲜,亦是OCR面临的核心挑战。

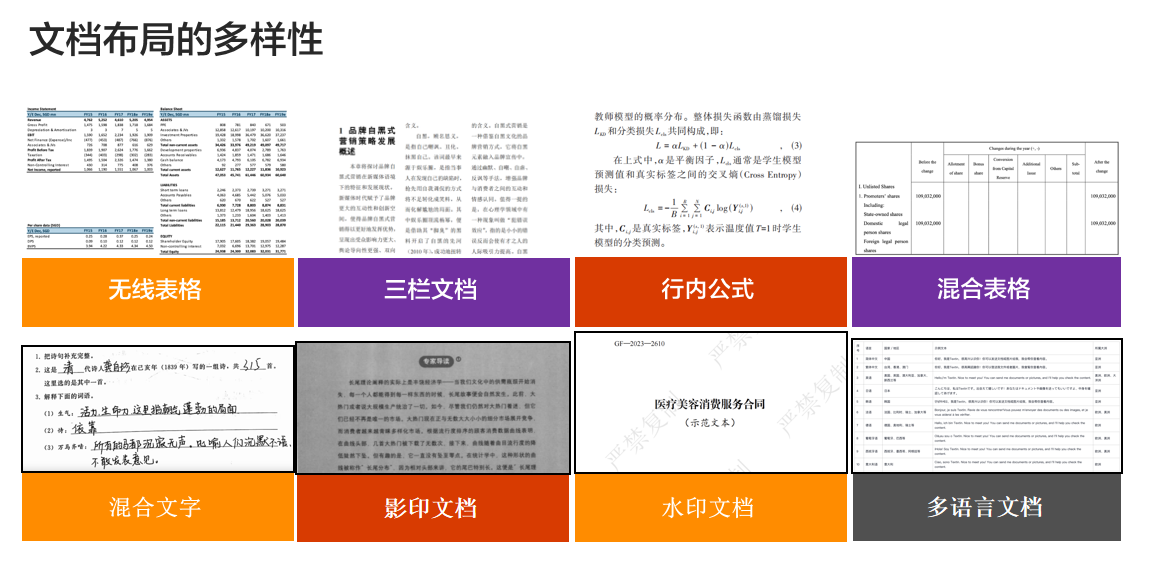

文档是一个复杂的多模态系统

传统OCR擅长“识别文字”,但在面对跨页表格、图表解读、逻辑结构理解时就“犯晕”了。文档的视觉结构(如段落边界、图表排列)、语义逻辑(如标题-内容配对、变量名与数据匹配)以及跨模态对齐(如图注与图表联动)都难以处理。

这就需要一种全新的解析范式——多模态文档解析。

合合信息三阶架构,支撑多模态文档的全局理解

合合信息多模态文档解析能力,基于“视觉-文本-逻辑”框架,实现对复杂文档的全局理解:

1. 视觉层(Visual Layer)

🚩目标:感知文档的物理结构与版面布局

✊核心能力:

-

基于计算机视觉(CV)模型,自动分割页面元素,如标题、段落、表格、图表等;

-

识别文档阅读顺序,恢复阅读流逻辑;

-

区分文档结构单元,实现版式与内容的同步还原。

2. 文本层(Text Layer)

🚩目标:提取语义信息并进行语言层分析

✊核心能力:

-

结合 OCR 与 NLP 模型进行文字识别与语义理解;

-

处理表格跨页、段落引用、公式上下文等复杂语义结构;

-

支持多语种识别与专业术语建模,适配多行业文档语境。

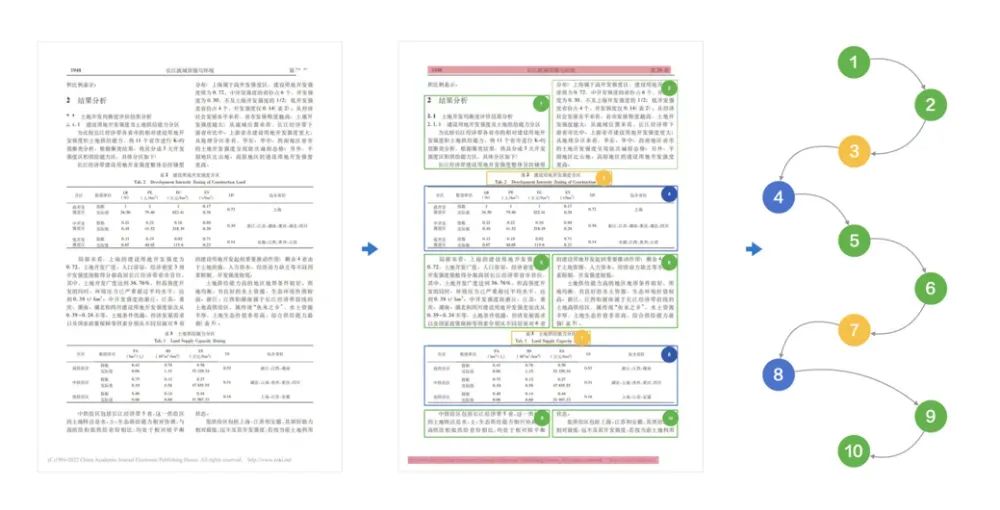

3. 逻辑层(Logic Layer)

🚩目标:建模文档中各元素之间的语义关系

✊核心能力:

-

基于图神经网络(GNN)构建文档结构图,刻画元素间的拓扑连接;

-

理解流程图节点关系、复合图表的数据依赖与指向性;

-

支持图文对照、表格字段归属等多层语义推理任务。

关键技术优势:打破模态壁垒,实现端到端理解

1. 跨页结构合并:避免分页导致的信息错位

在传统OCR中,分页会导致表格头部与数据行错位,合合信息多模态文档解析具备自动跨页结构对齐能力,智能合并表头与数据区,保证上下文连续性。

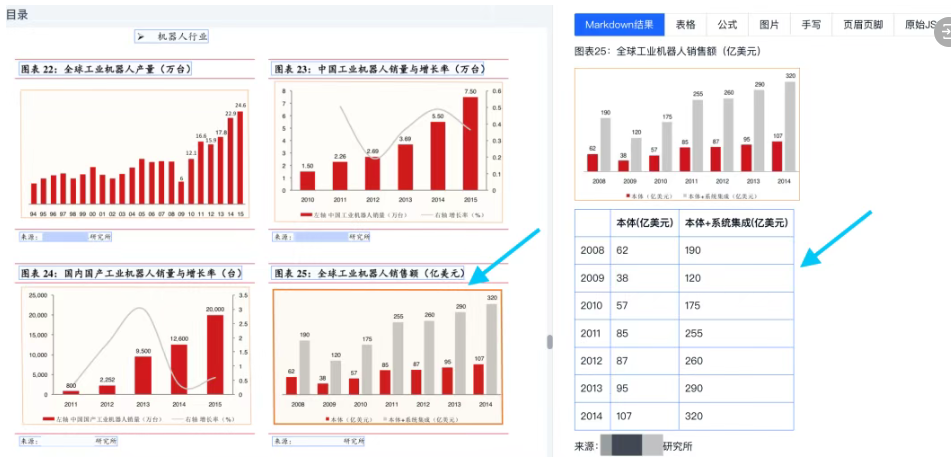

2. 视觉-语义双通道融合:实现图表智能抽取

通过视觉与语义双通道建模,精准对齐图像特征与文本描述:

识别图表中的坐标轴、颜色编码、图例与数据对应关系;

理解图注与图名语义,恢复图表上下文;

自动拆解“柱形图+折线图”类复合结构,提取为结构化数据表。

3. 结构化输出友好:助力下游模型高效调用

支持将解析结果以标准结构化格式(如 Markdown、Excel、JSON)输出,确保下游大模型、知识图谱、BI系统等可直接读取与调用。

更多产品细节

✅ 更高效:100页文档平均解析仅需1.5秒,支持批量处理

✅ 更稳定:日调用量可达百万级,系统成功率达99.999%

✅ 更灵活:支持API、SDK、离线包、私有化多种部署方式